這些年來,好的舊動作遊戲似乎在道路上失去了一點點,好像它在正確的情況下,儘管在各個方面都是視頻遊戲的基礎,但它在沒有很多讚美的情況下丟失了鏡頭。為了持續追求新趨勢,在具有角色扮演遊戲,日益複雜的挑戰或類似形式的雜種中,標準行動幾乎已成為稀有性。為此像這樣的遊戲船長可以是新鮮和原始的,自相矛盾的是採用非常經典的風格,根本不以此為榮,的確,他想從他的出現中以“第7代”的出現而努力去帕里,就好像它是直接來自Xbox 360和PS3時代的頭銜一樣。

事實是鮮血上尉和, 有效地,過去的遊戲:這些不僅僅是靈感的來源,而只是項目本身的起源從大約20年前開始,取消然後重生。

可以在2000年代初期跟踪,並在2012年的Xbox 360和PS3時代進行了一段時間,直到2012年,它被取消的一年,自2010年以來失去了踪跡。為了強調認真的意圖,最近也發布了一個演示,這使我們能夠提前嘗試幾分鐘的比賽,立即將我們置於對火和白色武器上的關注。

十七世紀的超級海盜

與1900年代初期的同名小說的聯繫相當不確定,超出了一般環境:關於歷史chat不休的時間並不多,但是儘管它是極其實用的船長,但血液仍有機會陷入一個非常特殊的氣候,講述了17世紀英格蘭海軍與西班牙之間衝突的經典海盜冒險故事。

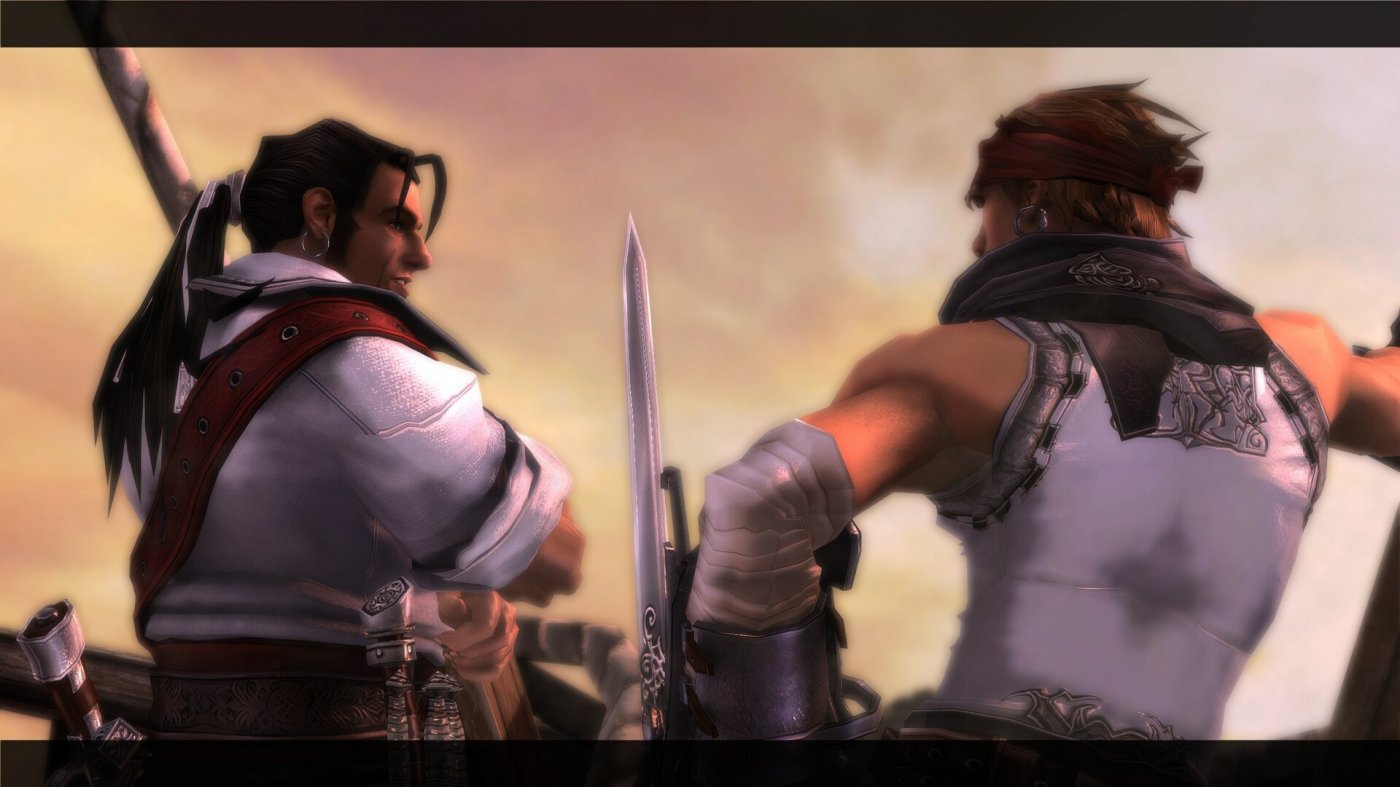

少數專家戰士,導航員和僱傭軍只是尋求黃金和輕鬆的獎勵,發現自己參與了皇家港海岸的西班牙海軍的暴力襲擊,從大陸上沖突,家具和海軍之戰開始了漫長的旅程。經過一些初步對話後,演示立即離開了行動空間,帶我們穿過一個強化的沿海城市的街道,在各個房間內,用劍和槍支與成群的敵人作戰,這些敵人從各個方向發動攻擊。

不幸的是,奇怪的是,試用版不允許您使用控制器並將鍵盤用於此類標題對遊戲體驗有些有害,但是很容易理解動作流程如何接近經典的滑動格鬥遊戲,並帶有回想起的影響力戰爭之神在Terza角色中的行動(原始),也許是遊戲玩法最接近的標題。

我們發現自己在敵人的努格利(Nugoli)之間移動,並使用組合中的串聯鏡頭(使用標準序列或特殊攻擊)連接到360度,並在必要時使用“ RAGE”模式增加了速度和阻力,但在有限的時間內。隨著國防率的提高,也有一些遊行和躲避變得很重要,但是不能說船長的血液像具有戰術和選擇性的戰鬥系統的標題一樣出現,首先要用壯觀的序列和相當流暢的節奏來娛樂,至少在某種程度上我們有機會嘗試。

過去的真實遊戲

履行毀滅性的組合一旦圖標出現在他們的腦海中,並在快速時間事件中,使用鑰匙旋轉劍,用火,執行老闆和更多的革命敵人,並在季節中參與階段,這是所有要素都非常緊密地想起了對動作遊戲的某種解釋,該元素可以回到幾年前,而這是更大的元素。

船長旁邊可能很好e實際上,這正是它的起源,儘管具有非常特殊的特徵,但在任何情況下都具有獨特性。自相矛盾的是,現在完全不在時間到來的事實,但是它以某種方式將其變成了原始且非常有趣的標題。如今,印度領域經常恢復的整個動作和有趣的風格,但採用絕對真正的方法。從這個意義上講,最大的問題是,一般的重複性似乎是由一個組合體系突出的,至少在演示中,它似乎並不是很深且發達,但是角色的某種進展仍然可以預見。

顯然,他的巨大生產外觀,但是20年前,它將其插入了一個奇怪的情況,好像是對經典遊戲的重新編輯,該遊戲是第一次到達市場上,而是以技術和時間的味道建造。

這圖形顯然,它必須從這個意義上進行解釋:由於其風格恢復了典型的海盜冒險故事的典型美學,但它仍然不可避免地是艱難的,儘管功能盡可能快地保持動作,但它仍然是令人愉快的。分辨率的增加導致了一般的“重新製作”風格效果,因為它現在是一款遊戲,這似乎很奇怪,但有助於其奇異的特徵。

對於那些希望與現代磨損相抵觸的舊動作遊戲的人來說,血液上尉正是所需要的:不是僅限於模仿的標題,而是直接來自2000年代的第一個十年。播放就像打開一種時間膠囊,直接在第三個人行動遵循魯蒂蘭蒂組合,壯觀的處決,快速時間事件之間的第一個戰爭之神之後,將自己投射出來。當然,作為遊戲情況和戰鬥的結構,一切都有點笨拙,機械和重複性,但是這種時間無生氣的人增加了海盜冒險的魅力,它最重要的是立即娛樂,並且似乎達到了我們所看到的意圖。

確定性

- 這是過去的動作遊戲:直接且沒有裝飾

- 海盜環境始終具有魅力

懷疑

- 顯然是機械和圖形的日期

- 目前的組合系統似乎有限